LangChain is het raamwerk dat meerdere afhankelijkheden en bibliotheken bevat die kunnen worden gebruikt om grote taalmodellen te bouwen. Deze modellen kunnen worden gebruikt voor interactie met mensen, maar eerst moet het model leren hoe de prompt/vraag van de mens kan worden begrepen. Daarvoor moet het model worden getraind op de promptsjablonen en vervolgens stelt de gebruiker de vraag binnen het gegeven sjabloon.

Deze handleiding illustreert het proces van het bouwen van promptsjablonen in LangChain.

Hoe prompt-sjablonen bouwen in LangChain?

Om promptsjablonen in LangChain te bouwen, doorloopt u eenvoudigweg de volgende handleiding met meerdere stappen:

Stap 1: Installeer modules en installatieomgeving

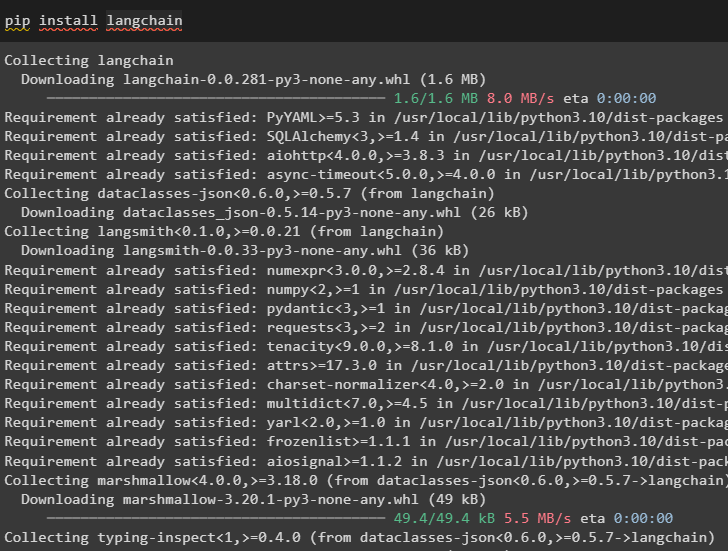

Start het proces van het bouwen van promptsjablonen in LangChain door het LangChain-framework te installeren:

pip installeer langchain

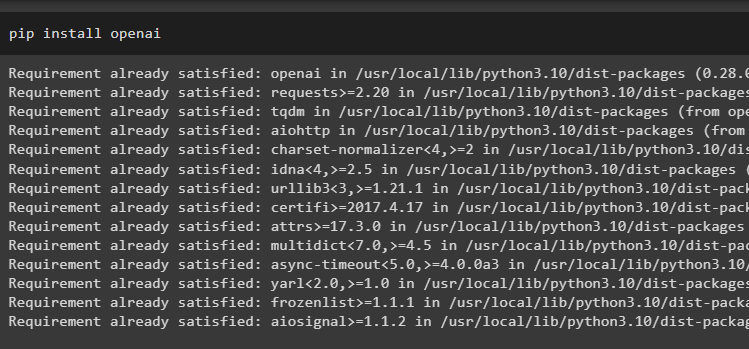

Installeer nu OpenAI-modules om toegang te krijgen tot de bibliotheken en een omgeving in te stellen die deze gebruikt:

pip installeer openai

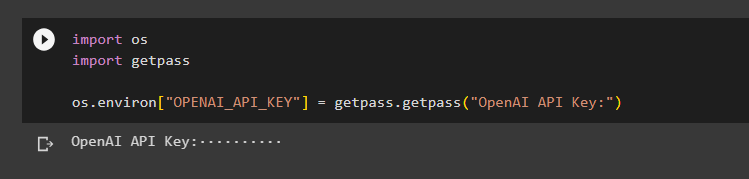

Stel de OpenAI-omgeving de os-bibliotheek gebruiken om toegang te krijgen tot het besturingssysteem en de OpenAI API-sleutel op te geven:

importeer onsgetpass importeren

os.environ['OPENAI_API_KEY'] = getpass.getpass('OpenAI API-sleutel:')

Stap 2: Prompt-sjabloon gebruiken

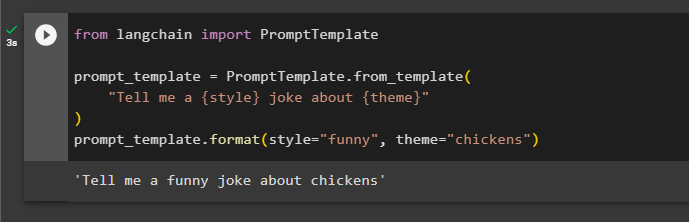

Na het installeren van LangChain importeert u eenvoudigweg de PromptTemplate-bibliotheek en bouwt u een sjabloon voor de zoekopdracht over een grap met enkele extra aspecten als variabelen zoals bijvoeglijk naamwoord, inhoud, enz.:

van langketenimport PromptTemplateprompt_template = PromptTemplate.van_template(

'Vertel me een {style} grap over {theme}'

)

prompt_template.format(style = 'grappig', thema = 'kippen')

De prompt is ingesteld en aan het model gegeven met de waarden van de variabele ingevoegd in de opdracht:

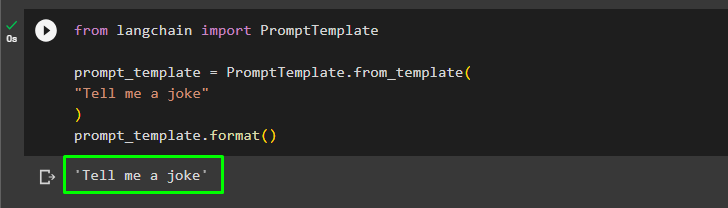

De gebruiker kan de promptsjabloon aanpassen met een eenvoudige vraag waarin om een grap wordt gevraagd:

van langketenimport PromptTemplateprompt_template = PromptTemplate.van_template(

'Vertel me een grap'

)

prompt_template.format()

De bovenstaande methode is voor een enkele vraag en antwoord, maar soms wil de gebruiker met het model communiceren in de vorm van een chat. In de volgende sectie wordt de indeling ervan uitgelegd.

Stap 3: Chatpromptsjabloon gebruiken

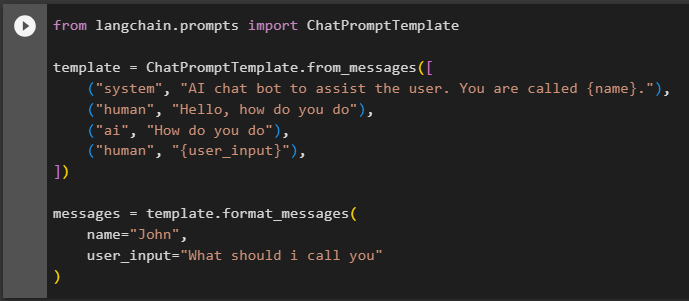

In deze sectie wordt de sjabloon uitgelegd voor een chatmodel dat is gebaseerd op een gesprekspatroon zoals twee mensen die met elkaar communiceren:

van langchain.prompts importeer ChatPromptTemplatesjabloon = ChatPromptTemplate.from_messages([

('systeem', 'AI-chatbot om de gebruiker te helpen. Je heet {naam}.'),

('mens', 'Hallo, hoe gaat het'),

('ai', 'Hoe gaat het met je'),

('menselijk', '{user_input}'),

])

berichten = sjabloon.format_messages(

naam = 'Jan',

user_input='Hoe moet ik je noemen'

)

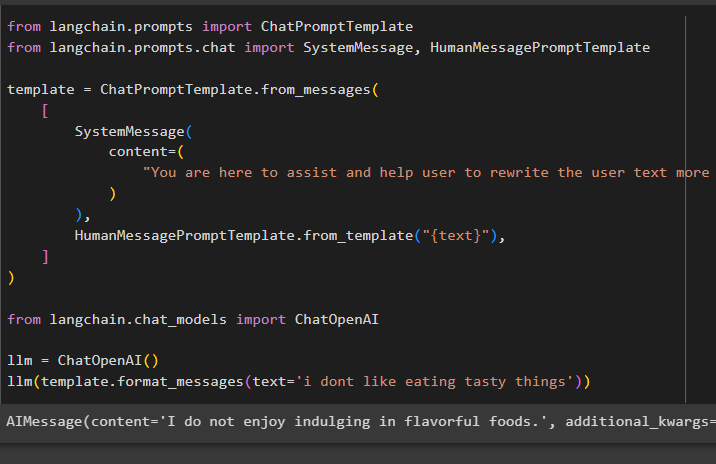

Nadat u de sjabloonstructuur hebt ingesteld, schrijft u eenvoudig enkele regels in de tekst om het model te vertellen wat er van wordt verwacht en gebruikt u de functie llm() om een prompt te geven:

van langchain.prompts importeer ChatPromptTemplatevan langchain.prompts.chat importeer SystemMessage, HumanMessagePromptTemplate

sjabloon = ChatPromptTemplate.from_messages(

[

Systeem bericht(

inhoud=(

'Je bent hier om de gebruiker te helpen en te helpen de gebruikerstekst effectiever te herschrijven'

)

),

HumanMessagePromptTemplate.from_template('{text}'),

]

)

van langchain.chat_models importeer ChatOpenAI

llm = ChatOpenAI()

llm(template.format_messages(text='ik hou niet van lekkere dingen eten'))

De SystemMessage()-methode bevat de inhoud van het antwoord op de query die in de LLM wordt gebruikt:

Dat gaat allemaal over het bouwen van promptsjablonen in LangChain.

Conclusie

Om een promptsjabloon in LangChain te bouwen, installeert u eenvoudig de LangChain- en OpenAI-modules om een omgeving in te stellen met behulp van de OpenAI API-sleutel. Maak daarna een promptsjabloon voor een enkele prompt, zoals het vragen om een grap of een enkele vraag over wat dan ook. Een andere methode is het aanpassen van een sjabloon voor een chatmodel op basis van het interactieproces tussen twee verschillende mensen. Dit bericht heeft het proces geïllustreerd van het bouwen van een promptsjabloon in LangChain.