In dit tijdperk zijn Transformers de krachtigste modellen die de beste resultaten hebben opgeleverd in meerdere NLP-bewerkingen (Natural Language Processing). Aanvankelijk werd het gebruikt voor taalmodelleringstaken, waaronder het genereren van tekst, classificatie, automatische vertaling en nog veel meer. Maar nu wordt het ook gebruikt voor objectherkenning, beeldclassificatie en meerdere andere computervisietaken.

In deze zelfstudie geven we de procedure voor het uitvoeren van de tekstclassificatie met behulp van Transformers.

Hoe tekstclassificatie uitvoeren met behulp van Transformers?

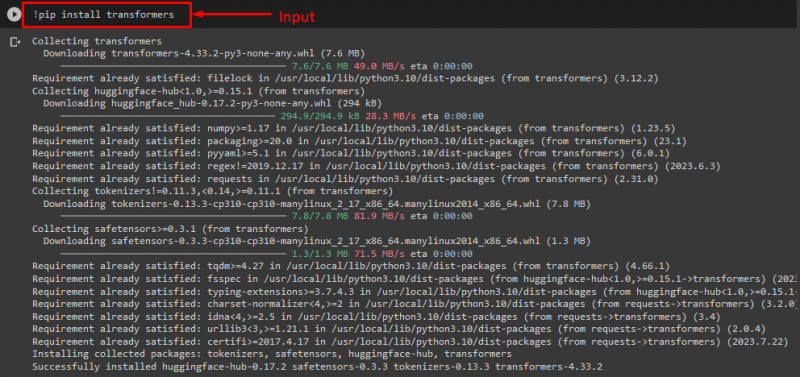

Om de tekstclassificatie uit te voeren met behulp van Transformers, installeert u eerst de “ transformatoren ”bibliotheek door de opgegeven opdracht uit te voeren:

! Pip installeren transformatoren

Zoals u kunt zien, is de opgegeven bibliotheek met succes geïnstalleerd:

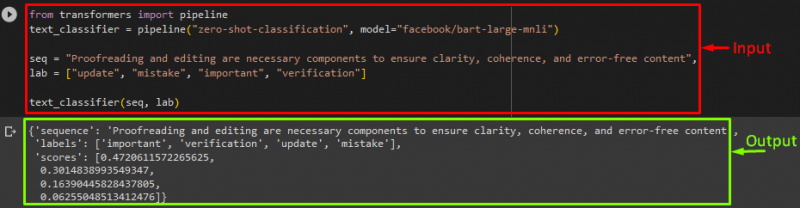

Importeer vervolgens de “ pijpleiding ' van de ' transformatoren ' bibliotheek:

van de importpijplijn van transformatoren

Hier de ' pijpleiding ” omvat de NLP-taak die we moeten uitvoeren en het gewenste transformatormodel voor deze operatie, samen met de tokenizer.

Opmerking: De tokenizer wordt gebruikt om verwerking uit te voeren op de tekst die van de invoer van het model moet worden voorzien door tekst in tokens te scheiden.

Gebruik daarna de “ pijpleiding() ' functie en geef het de ' zero-shot-classificatie ' als argument. Geef vervolgens een andere parameter door die ons model is. Wij gebruiken Facebook’s “ BART transformatormodel. Hier gebruiken we de tokenizer niet omdat deze automatisch kan worden afgeleid door het opgegeven model:

text_classifier = pijplijn ( 'zero-shot-classificatie' , model = 'facebook/bart-large-mnli' )

Verklaar nu de “ volg 'variabele die onze invoertekst bevat die moet worden geclassificeerd. Vervolgens bieden we de categorieën aan waarin we de tekst willen classificeren en opslaan in de ' laboratorium ”die bekend staat als labels:

laboratorium = [ 'update' , 'fout' , 'belangrijk' , 'verificatie' ]

Voer ten slotte de pijplijn samen met de invoer uit:

Na het uitvoeren van de pijplijn voorspelde het model, zoals u kunt zien, dat onze opgegeven volgorde zou worden geclassificeerd:

Extra informatie: Als je de prestaties van het model wilt versnellen, moet je de GPU gebruiken. Zo ja, dan kunt u voor dat doel een apparaatargument voor de pijplijn opgeven en dit instellen op “ 0 ” om de GPU te gebruiken.

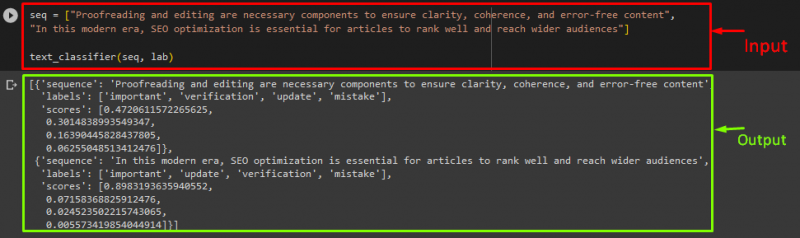

Als u de tekst in meer dan één reeks/invoertekstinstructie wilt classificeren, kunt u deze aan een lijst toevoegen en deze als invoer aan de pijplijnen doorgeven. Bekijk daarvoor het codefragment:

volg = [ 'Proeflezen en redigeren zijn noodzakelijke componenten om duidelijkheid, samenhang en foutloze inhoud te garanderen' ,'In dit moderne tijdperk is SEO-optimalisatie essentieel om artikelen goed te laten scoren en een breder publiek te bereiken' ]

tekst_classificator ( volg , laboratorium )

Uitvoer

Dat is het! We hebben de eenvoudigste manier samengesteld om de tekstclassificatie uit te voeren met behulp van Transformers.

Conclusie

Transformers worden gebruikt om taalmodelleringstaken uit te voeren, zoals het genereren van tekst, tekstclassificatie en machinevertaling, evenals computervisietaken, waaronder objectherkenning en beeldclassificatie. In deze zelfstudie hebben we het proces voor het uitvoeren van tekstclassificatie met Transformers geïllustreerd.