De functie pipeline() is een integraal onderdeel van de Transformer-bibliotheek. Er zijn verschillende invoergegevens nodig waarin we een gevolgtrekkingstaak, modellen, tokenisatiemechanisme, enz. kunnen definiëren. Een pipeline()-functie wordt voornamelijk gebruikt om NLP-taken uit te voeren op een of meerdere teksten. Het voert voorbewerking uit op de invoer en nabewerking op basis van het model om voor mensen leesbare uitvoer en nauwkeurige voorspellingen met maximale nauwkeurigheid te genereren.

Dit artikel behandelt de volgende aspecten:

- Wat is de bibliotheek met knuffelgezichtsgegevenssets?

- Hoe pijplijnen toe te passen op een dataset in Hugging Face?

Wat is de knuffelgezicht-gegevenssetbibliotheek?

Een Hugging Face-datasetbibliotheek is een API die verschillende openbare datasets bevat en een gemakkelijke manier biedt om deze te downloaden. Deze bibliotheek kan in de applicatie worden geïmporteerd en geïnstalleerd met behulp van de “ Pip commando. Voor een praktische demonstratie van het downloaden en installeren van datasets van de Hugging Face-bibliotheek kunt u hier terecht Google Colab-link. U kunt meerdere datasets downloaden van de Gegevenssethub voor knuffelgezichten.

Leer meer over de werking van de pipeline() functie door dit artikel te raadplegen “ Hoe gebruik ik de Pipeline()-functie in Transformers? ”.

Hoe pijplijnen toe te passen op een dataset in Hugging Face?

Hugging Face biedt verschillende openbare datasets die eenvoudig kunnen worden geïnstalleerd met behulp van éénregelige code. In dit artikel zullen we een praktische demonstratie zien van het toepassen van pijplijnen op deze datasets. Er zijn twee manieren waarop pijplijnen op de dataset kunnen worden geïmplementeerd.

Methode 1: Iteratiemethode gebruiken

De functie pipeline() kan ook over een dataset en model worden herhaald. Volg hiervoor de onderstaande stappen:

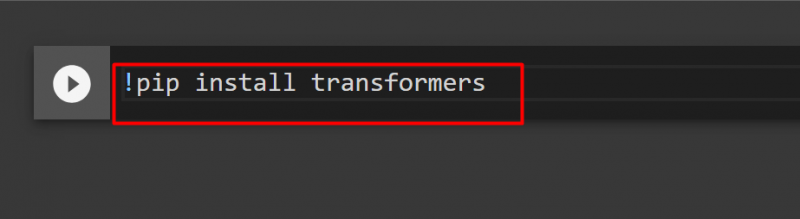

Stap 1: Installeer Transformer-bibliotheek

Om de Transformer-bibliotheek te installeren, geeft u de volgende opdracht op:

!pip installeert transformatoren

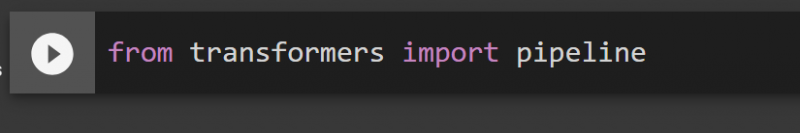

Stap 2: Pijpleidingen importeren

We kunnen de pijplijn importeren vanuit de Transformer-bibliotheek. Geef hiervoor het volgende commando:

van de importpijplijn van transformatoren

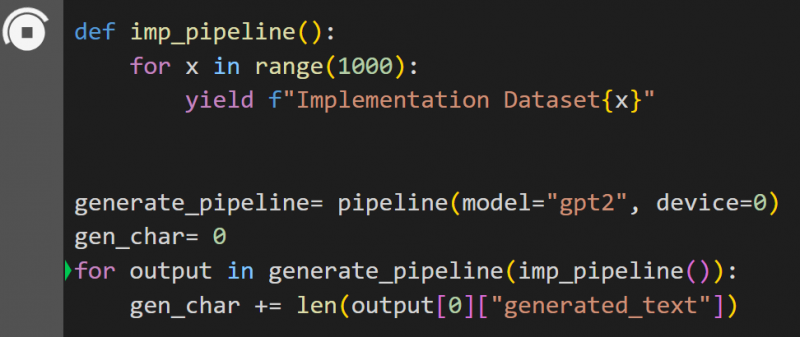

Stap 3: Pipeline implementeren

Hier wordt de functie pipeline() geïmplementeerd op het model “ gpt2 ”. U kunt modellen downloaden van de Knuffelen Gezicht Model Hub:

def imp_pipeline():voor x binnen bereik(1000):

opbrengst f'Implementatiegegevensset{x}'

genereren_pipeline= pijplijn(model=”gpt2”, apparaat=0)

gen_char= 0

voor uitvoer in genereren_pipeline(imp_pipeline()):

gen_char += len(output[0]['gegenereerde_tekst'])

In deze code wordt de “ genereren_pipeline ” is een variabele die de functie pipeline() bevat met model “ gpt2 ”. Wanneer het wordt aangeroepen met de “ imp_pipeline() ”-functie herkent het automatisch de gegevens die worden verhoogd met het opgegeven bereik tot 1000:

Dit zal enige tijd duren om te trainen. De link naar de Google Co wordt ook gegeven.

Methode 2: Gegevenssetsbibliotheek gebruiken

In deze methode zullen we de implementatie van de pijplijn demonstreren met behulp van de bibliotheek 'datasets':

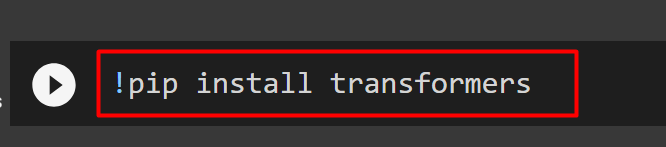

Stap 1: Installeer Transformer

Om de Transformer-bibliotheek te installeren, geeft u de volgende opdracht op:

!pip installeert transformatoren

Stap 2: Installeer de gegevenssetbibliotheek

Zoals de “ datasets ”bibliotheek alle openbare datasets bevat, kunnen we deze installeren met behulp van de volgende opdracht. Door het installeren van de “ datasets ”-bibliotheek, kunnen we elke dataset rechtstreeks importeren door de naam ervan op te geven:

!pip installeer datasets

Stap 3: Gegevenssetpijplijn

Gebruik de volgende code om een pijplijn op de gegevensset te bouwen. KeyDataset is een functie die alleen die waarden uitvoert die de gebruiker interesseren:

van transformers.pipelines.pt_utils importeer KeyDatasetvan de importpijplijn van transformatoren

uit datasets importeer load_dataset

gen_pipeline = pijplijn (model = 'hf-internal-testing/tiny-random-wav2vec2', apparaat = 0)

loaddataset = load_dataset('hf-internal-testing/librispeech_asr_dummy', 'clean', split='validation[:10]') voor uitvoer in gen_pipeline(KeyDataset(loaddataset, 'audio')):

print('De uitvoer wordt nu afgedrukt')

afdrukken ('---------------')

afdrukken(uitvoer)

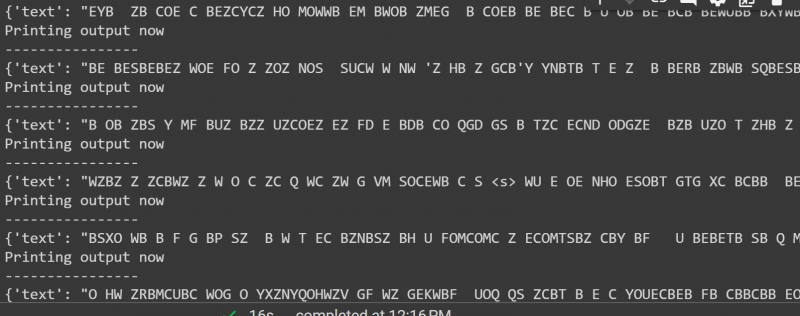

De uitvoer van de bovenstaande code wordt hieronder gegeven:

Dat komt allemaal uit deze gids. De link naar de Google Co wordt ook genoemd in dit artikel

Conclusie

Om pijplijnen op de dataset toe te passen, kunnen we een dataset herhalen met behulp van een pijplijn() functie of de “ datasets ' bibliotheek. Hugging Face biedt de GitHub-repositorylink aan zijn gebruikers voor zowel datasets als modellen die kunnen worden gebruikt op basis van de vereisten. Dit artikel biedt een uitgebreide handleiding voor het toepassen van pijplijnen op een gegevensset in Transformers.