Syntaxis:

Er bestaat een verscheidenheid aan services die Hugging Face biedt, maar een van de meest gebruikte services is 'API'. API maakt de interactie mogelijk van de vooraf getrainde AI en grote taalmodellen met verschillende applicaties. Hugging Face biedt de API's voor verschillende modellen, zoals hieronder vermeld:

- Modellen voor het genereren van tekst

- Vertaal modellen

- Modellen voor de analyse van de sentimenten

- Modellen voor de ontwikkeling van virtuele agenten (intelligente chatbots)

- Classificatie en de regressiemodellen

Laten we nu de methode ontdekken om onze gepersonaliseerde inferentie-API van Hugging Face te krijgen. Om dit te doen, moeten we ons eerst registreren op de officiële website van Hugging Face. Word lid van deze gemeenschap van Hugging Face door u met uw inloggegevens aan te melden bij deze website.

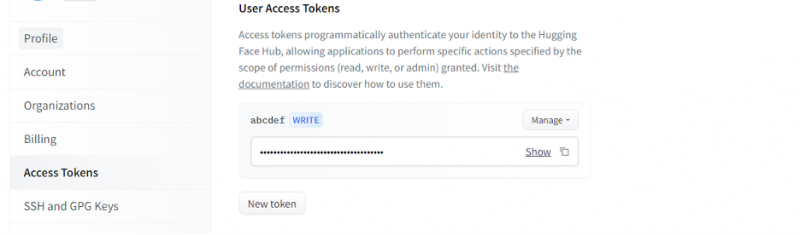

Zodra we een account op Hugging Face hebben, moeten we nu de inferentie-API aanvragen. Om de API aan te vragen, gaat u naar de accountinstellingen en selecteert u 'Toegangstoken'. Er wordt een nieuw venster geopend. Selecteer de optie 'Nieuw token' en genereer vervolgens het token door eerst de naam van het token en zijn rol als 'SCHRIJVEN' op te geven. Er wordt een nieuw token gegenereerd. Nu moeten we dit token opslaan. Tot nu toe hebben we ons token van de Hugging Face. In het volgende voorbeeld zullen we zien hoe we dit token kunnen gebruiken om een inferentie-API te krijgen.

Voorbeeld 1: Prototype maken met de Hugging Face Inference API

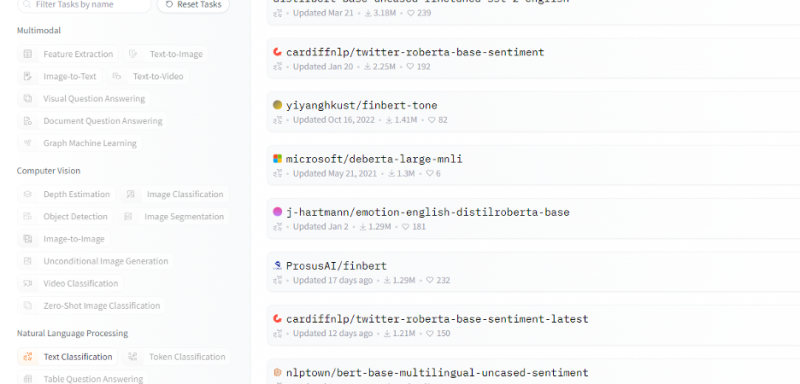

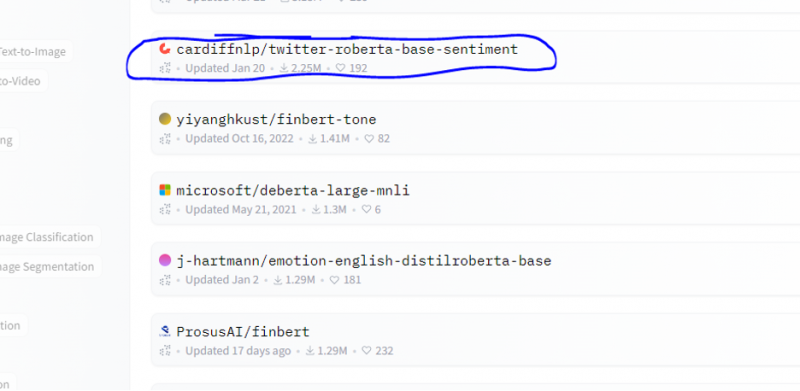

Tot nu toe hebben we de methode besproken om aan de slag te gaan met Hugging Face en we hebben een token van Hugging Face geïnitialiseerd. Dit voorbeeld laat zien hoe we dit nieuw gegenereerde token kunnen gebruiken om een inferentie-API voor een specifiek model (machine learning) te krijgen en daarmee voorspellingen te doen. Selecteer op de startpagina van Hugging Face elk model waarmee u wilt werken en dat relevant is voor uw probleem. Laten we zeggen dat we willen werken met de tekstclassificatie of het sentimentanalysemodel zoals weergegeven in het volgende fragment van de lijst met deze modellen:

Uit dit model kiezen we het sentimentanalysemodel.

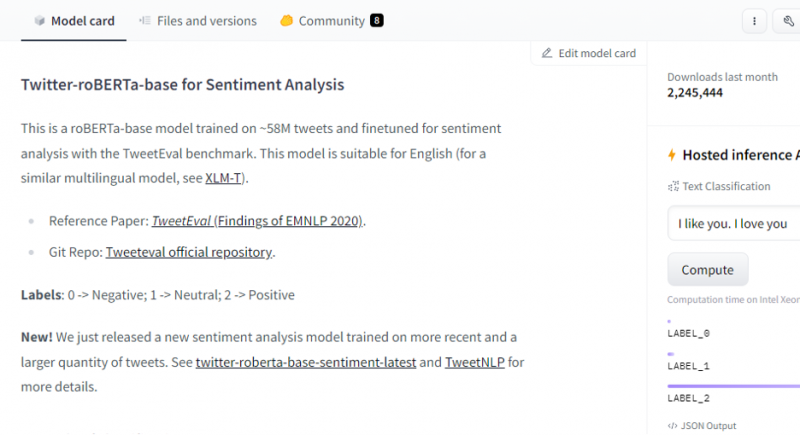

Na het selecteren van het model verschijnt de modelkaart. Deze modelkaart bevat informatie over de trainingsdetails van het model en welke kenmerken het model heeft. Ons model is roBERTa-base dat is getraind op de 58 miljoen tweets voor sentimentanalyse. Dit model heeft drie hoofdklasselabels en categoriseert elke invoer in de relevante klasselabels.

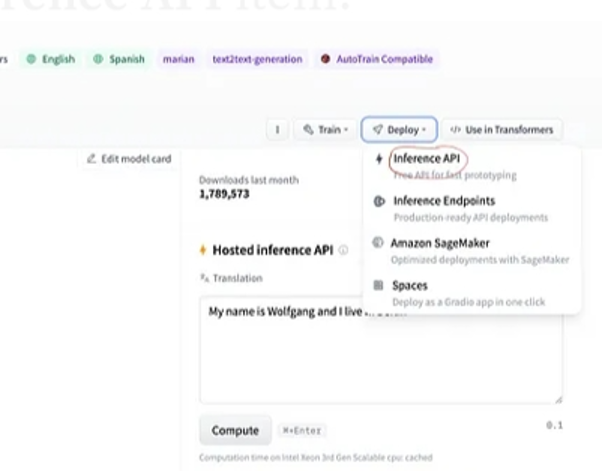

Als we na de selectie van het model de implementatieknop selecteren die zich in de rechterbovenhoek van het venster bevindt, wordt er een vervolgkeuzemenu geopend. Vanuit dit menu moeten we de optie 'Inference API' selecteren.

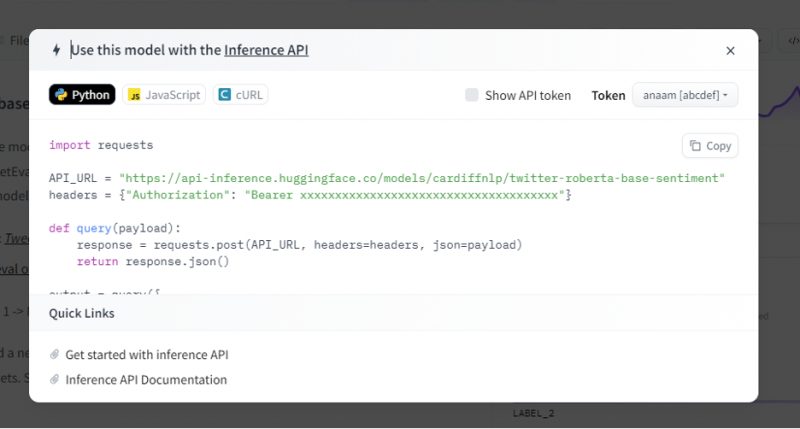

De inferentie-API geeft vervolgens een hele uitleg over hoe dit specifieke model met deze inferentie kan worden gebruikt en stelt ons in staat om snel het prototype voor het AI-model te maken. Het inferentie-API-venster geeft de code weer die is geschreven in het script van Python.

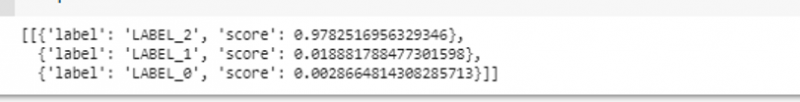

We kopiëren deze code en voeren deze code uit in een van de Python IDE's. Hiervoor gebruiken we Google Colab. Na het uitvoeren van deze code in de Python-shell, retourneert het een uitvoer die wordt geleverd met de score en de labelvoorspelling. Dit label en deze score worden gegeven op basis van onze input, aangezien we het model 'tekst-sentimentanalyse' hebben gekozen. Vervolgens is de invoer die we aan het model geven een positieve zin en het model is vooraf getraind op drie labelklassen: label 0 impliceert negatief, label1 impliceert neutraal en label 2 is ingesteld op positief. Aangezien onze invoer een positieve zin is, is de scorevoorspelling van het model hoger dan die van de andere twee labels, wat betekent dat het model de zin als een 'positieve' voorspelde.

importeren aanvragenAPI_URL = 'https://api-inference.huggingface.co/models/cardiffnlp/twitter-roberta-base-sentiment'

koppen = { 'Autorisatie' : 'Donder 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' }

def vraag ( lading ) :

antwoord = aanvragen. na ( API_URL , koppen = koppen , json = lading )

opbrengst antwoord. json ( )

uitvoer = vraag ( {

'ingangen' : 'Ik voel me goed als je bij me bent' ,

} )

Uitgang:

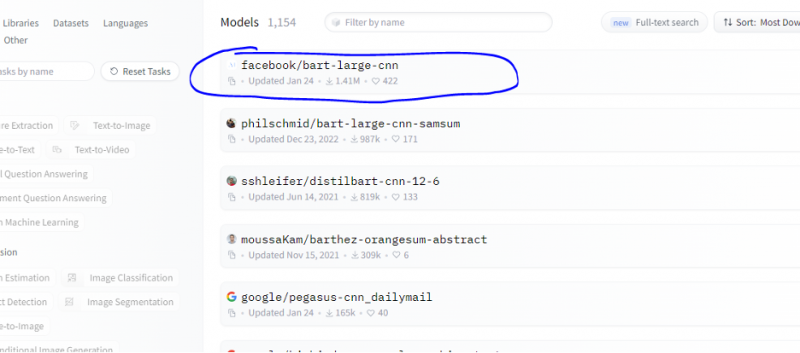

Voorbeeld 2: Samenvattingsmodel door middel van inferentie

We volgen dezelfde stappen als in het vorige voorbeeld en maken een prototype van de samenvattingsmodelbus met behulp van de inferentie-API van Hugging Face. Het samenvattingsmodel is een vooraf getraind model dat de hele tekst samenvat die we eraan geven als input. Ga naar het Hugging Face-account, klik op het model in de bovenste menubalk en kies vervolgens het model dat relevant is voor de samenvatting, selecteer het en lees de modelkaart zorgvuldig.

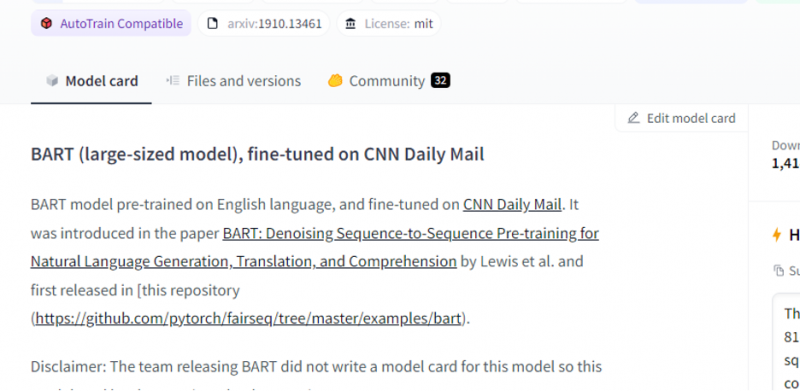

Het model dat we hebben gekozen is een vooraf getraind BART-model en is nauwkeurig afgestemd op de dataset CNN dail mail. BART is een model dat het meest lijkt op het BERT-model dat een encoder en decoder heeft. Dit model is effectief wanneer het is afgestemd op begrip, samenvatting, vertaling en tekstgenererende taken.

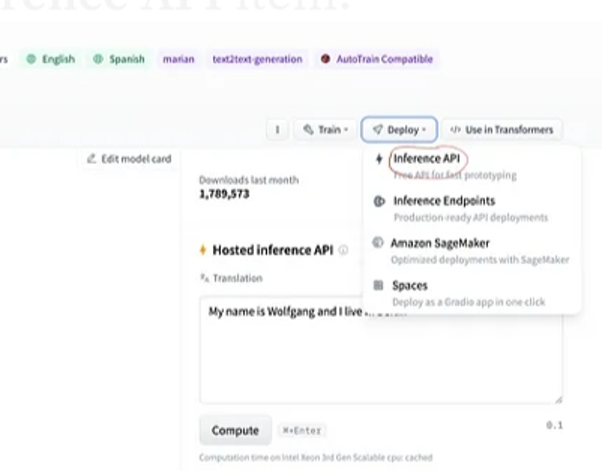

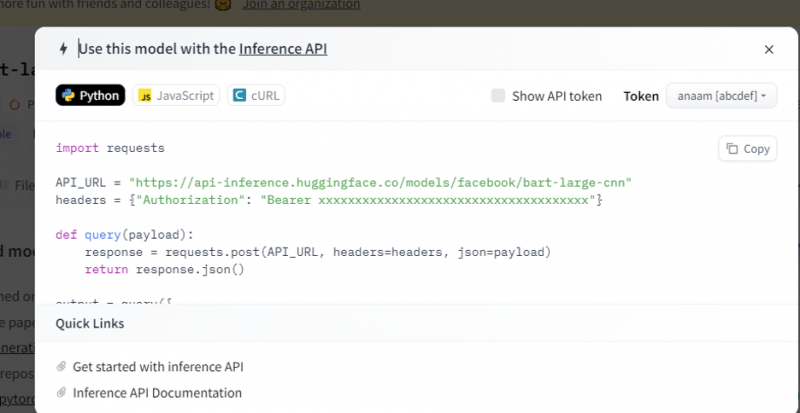

Kies vervolgens de knop 'implementatie' in de rechterbovenhoek en selecteer de inferentie-API in het vervolgkeuzemenu. De deductie-API opent een ander venster met de code en de aanwijzingen om dit model met deze gevolgtrekking te gebruiken.

Kopieer deze code en voer deze uit in een Python-shell.

Het model retourneert de uitvoer die de samenvatting is van de invoer die we eraan hebben gegeven.

Conclusie

We hebben aan de Hugging Face Inference API gewerkt en geleerd hoe we de programmeerbare interface van deze applicatie kunnen gebruiken om met de vooraf getrainde taalmodellen te werken. De twee voorbeelden die we in het artikel hebben gedaan, waren voornamelijk gebaseerd op de NLP-modellen. Hugging Face API kan wonderen verrichten als we een snel prototype willen ontwikkelen door de snelle integratie van AI-modellen in onze applicaties te bieden. Kortom, Hugging Face heeft oplossingen voor al uw problemen, van leren met versterking tot computervisie.