De “datasets”-bibliotheek van Hugging Face biedt een handige manier om met de datasets te werken en deze te manipuleren voor taken op het gebied van natuurlijke taalverwerking. Een nuttige functie die door de bibliotheek wordt aangeboden, is concatenate_datasets() waarmee u meerdere datasets kunt samenvoegen tot één enkele dataset. Hieronder volgt een kort overzicht van de functie concatenate_datasets() en hoe u deze kunt gebruiken.

concatenate_datasets()

Beschrijving:

De ‘datasets’-bibliotheek van Hugging Face biedt de functie concatenate_datasets(). Het wordt gebruikt om meerdere datasets samen te voegen en ze te combineren tot een enkele dataset langs een gespecificeerde as. Deze functie is met name handig als u meerdere datasets heeft die dezelfde structuur delen en u deze wilt samenvoegen tot een uniforme dataset voor verdere verwerking en analyse.

Syntaxis:

van datasets importeren concatenate_datasets

aaneengeschakelde_dataset = concatenate_datasets ( datasets , as = 0 , informatie = Geen )

Parameters:

datasets (lijst met gegevenssets): een lijst met gegevenssets die u wilt samenvoegen. Deze gegevenssets moeten compatibele functies hebben, wat betekent dat ze hetzelfde schema, dezelfde kolomnamen en gegevenstypen hebben.

as (int, optioneel, default=0): De as waarlangs de aaneenschakeling moet worden uitgevoerd. Voor de meeste NLP-datasets wordt de standaardwaarde 0 gebruikt, wat betekent dat de datasets verticaal aaneengeschakeld zijn. Als u de as=1 instelt, worden de gegevenssets horizontaal aaneengeschakeld, ervan uitgaande dat ze verschillende kolommen als objecten hebben.

informatie (datasets.DatasetInfo, optioneel): de informatie over de aaneengeschakelde gegevensset. Als deze niet wordt opgegeven, wordt de informatie afgeleid van de eerste gegevensset in de lijst.

Geeft terug:

aaneengeschakelde_dataset (Dataset): de resulterende gegevensset na het samenvoegen van alle invoergegevenssets.

Voorbeeld:

# Stap 1: Installeer de datasetbibliotheek# Je kunt het installeren met pip:

# !pip-installatiegegevenssets

# Stap 2: Importeer de vereiste bibliotheken

van datasets importeren laad_gegevensset , concatenate_datasets

# Stap 3: Laad de IMDb-filmrecensiedatasets

# We gebruiken twee IMDb-datasets, één voor positieve recensies

#en nog een voor negatieve recensies.

# Laad 2500 positieve recensies

gegevensset_pos = laad_gegevensset ( 'imdb' , gesplitst = 'trein[:2500]' )

# Laad 2500 negatieve recensies

dataset_neg = laad_gegevensset ( 'imdb' , gesplitst = 'trein[-2500:]' )

# Stap 4: Voeg de datasets samen

# We voegen beide datasets samen langs as=0, zoals ze hebben gedaan

hetzelfde schema ( dezelfde kenmerken ) .

aaneengeschakelde_dataset = concatenate_datasets ( [ gegevensset_pos , dataset_neg ] )

# Stap 5: Analyseer de samengevoegde dataset

# Laten we voor de eenvoud het aantal positieve en negatieve tellen

# beoordelingen in de samengevoegde dataset.

aantal_positieve_beoordelingen = som ( 1 voor etiket in

aaneengeschakelde_dataset [ 'etiket' ] als etiket == 1 )

aantal_negatieve_beoordelingen = som ( 1 voor etiket in

aaneengeschakelde_dataset [ 'etiket' ] als etiket == 0 )

# Stap 6: Geef de resultaten weer

afdrukken ( 'Aantal positieve recensies:' , aantal_positieve_beoordelingen )

afdrukken ( 'Aantal negatieve recensies:' , aantal_negatieve_beoordelingen )

# Stap 7: Print een paar voorbeeldrecensies uit de samengevoegde dataset

afdrukken ( ' \N Enkele voorbeeldrecensies:' )

voor i in bereik ( 5 ) :

afdrukken ( F 'Review {i + 1}: {concatenated_dataset['text'][i]}' )

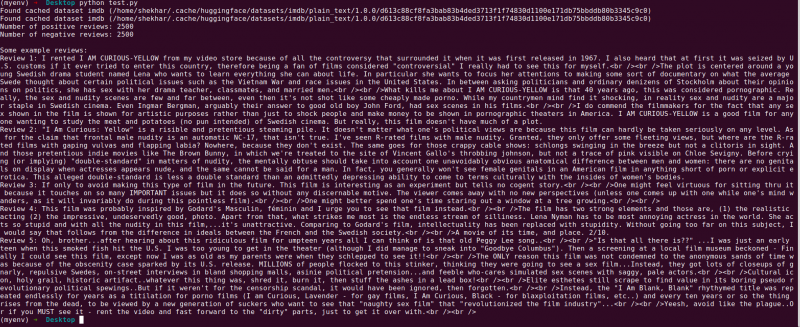

Uitgang:

Het volgende is de uitleg voor het ‘datasets’-bibliotheekprogramma van Hugging Face, dat twee IMDb-filmrecensiedatasets samenvoegt. Dit verklaart het doel van het programma, het gebruik ervan en de stappen die bij de code betrokken zijn.

Laten we een meer gedetailleerde uitleg geven van elke stap in de code:

# Stap 1: Importeer de vereiste bibliothekenvan datasets importeren laad_gegevensset , concatenate_datasets

In deze stap importeren we de benodigde bibliotheken voor het programma. We hebben de functie 'load_dataset' nodig om de IMDb-filmrecensiedatasets te laden, en de 'concatenate_datasets' om ze later samen te voegen.

# Stap 2: Laad de IMDb Movie Review-gegevenssets# Laad 2500 positieve recensies

gegevensset_pos = laad_gegevensset ( 'imdb' , gesplitst = 'trein[:2500]' )

# Laad 2500 negatieve recensies

dataset_neg = laad_gegevensset ( 'imdb' , gesplitst = 'trein[-2500:]' )

Hier gebruiken we de functie 'load_dataset' om twee subsets van de IMDb-dataset op te halen. De “dataset_pos” bevat 2500 positieve recensies en de “dataset_neg” bevat 2500 negatieve recensies. We gebruiken de split-parameter om het bereik van de te laden voorbeelden te specificeren, waardoor we een subset van de volledige dataset kunnen selecteren.

# Stap 3: Voeg de datasets samenaaneengeschakelde_dataset = concatenate_datasets ( [ gegevensset_pos , dataset_neg ] )

In deze stap voegen we de twee subsets van de IMDb-dataset samen tot een enkele dataset genaamd “concatenated_dataset”. We gebruiken de functie “concatenate_datasets” en geven deze door met een lijst die de twee datasets bevat die moeten worden samengevoegd. Omdat beide datasets dezelfde kenmerken hebben, voegen we ze samen langs as=0, wat betekent dat de rijen op elkaar worden gestapeld.

# Stap 4: Analyseer de samengevoegde datasetaantal_positieve_beoordelingen = som ( 1 voor etiket in

aaneengeschakelde_dataset [ 'etiket' ] als etiket == 1 )

aantal_negatieve_beoordelingen = som ( 1 voor etiket in

aaneengeschakelde_dataset [ 'etiket' ] als etiket == 0 )

Hier voeren we een eenvoudige analyse uit van de aaneengeschakelde dataset. We gebruiken de lijstbegrippen samen met de ‘som’-functie om het aantal positieve en negatieve recensies te tellen. We doorlopen de “ label”-kolom van de “concatenated_dataset” en verhoog de tellingen wanneer we een positief label (1) of een negatief label (0) tegenkomen.

# Stap 5: Geef de resultaten weerafdrukken ( 'Aantal positieve recensies:' , aantal_positieve_beoordelingen )

afdrukken ( 'Aantal negatieve recensies:' , aantal_negatieve_beoordelingen )

In deze stap drukken we de resultaten van onze analyse af: het aantal positieve en negatieve recensies in de samengevoegde dataset.

# Stap 6: Print een paar voorbeeldrecensiesafdrukken ( ' \N Enkele voorbeeldrecensies:' )

voor i in bereik ( 5 ) :

afdrukken ( F 'Review {i + 1}: {concatenated_dataset['text'][i]}' )

Ten slotte presenteren we enkele voorbeeldrecensies uit de samengevoegde dataset. We doorlopen de eerste vijf voorbeelden in de dataset en drukken hun tekstinhoud af met behulp van de kolom 'tekst'.

Deze code demonstreert een eenvoudig voorbeeld van het gebruik van de ‘datasets’-bibliotheek van Hugging Face om de IMDb-filmrecensiedatasets te laden, samen te voegen en te analyseren. Het benadrukt het vermogen van de bibliotheek om de verwerking van NLP-datasets te stroomlijnen en toont haar potentieel voor het bouwen van meer geavanceerde modellen en toepassingen voor natuurlijke taalverwerking.

Conclusie

Het Python-programma dat de ‘datasets’-bibliotheek van Hugging Face gebruikt, demonstreert met succes de aaneenschakeling van twee IMDb-filmrecensiedatasets. Door de subsets van positieve en negatieve beoordelingen te laden, combineert het programma deze in één enkele dataset met behulp van de functie concatenate_datasets(). Vervolgens wordt een eenvoudige analyse uitgevoerd door het aantal positieve en negatieve recensies in de gecombineerde dataset te tellen.

De ‘datasets’-bibliotheek vereenvoudigt het proces van het hanteren en manipuleren van de NLP-datasets, waardoor het een krachtig hulpmiddel wordt voor onderzoekers, ontwikkelaars en NLP-beoefenaars. Met zijn gebruiksvriendelijke interface en uitgebreide functionaliteiten maakt de bibliotheek een moeiteloze voorverwerking, verkenning en transformatie van gegevens mogelijk. Het programma dat in deze documentatie wordt gepresenteerd, dient als een praktisch voorbeeld van hoe de bibliotheek kan worden ingezet om de gegevensaaneenschakeling en analysetaken te stroomlijnen.

In praktijkscenario's kan dit programma dienen als basis voor complexere taken voor de verwerking van natuurlijke taal, zoals sentimentanalyse, tekstclassificatie en taalmodellering. Met behulp van de ‘datasets’-bibliotheek kunnen onderzoekers en ontwikkelaars de grootschalige datasets efficiënt beheren, experimenten vergemakkelijken en de ontwikkeling van ultramoderne NLP-modellen versnellen. Over het geheel genomen is de ‘datasets’-bibliotheek van Hugging Face een essentiële troef bij het nastreven van vooruitgang in de verwerking en het begrip van natuurlijke taal.