Large Language Models of LLM's zijn een krachtig soort neuraal netwerkalgoritme om chatbots te bouwen die gegevens ophalen met behulp van opdrachten in natuurlijke talen. Met LLM's kunnen machines/computers natuurlijke taal beter begrijpen en taal genereren zoals mensen. De LangChain-module werkt ook om NLP-modellen te bouwen. Het heeft echter geen LLM, maar maakt interactie met veel verschillende LLM's mogelijk.

In deze gids wordt het proces van interactie met grote taalmodellen uitgelegd met behulp van LangChain.

Hoe om te gaan met LLM's met behulp van LangChain?

Om met LLM's te communiceren met behulp van LangChain, volgt u eenvoudigweg deze eenvoudige stapsgewijze handleiding met voorbeelden:

Installeer modules voor interactie met LLM's

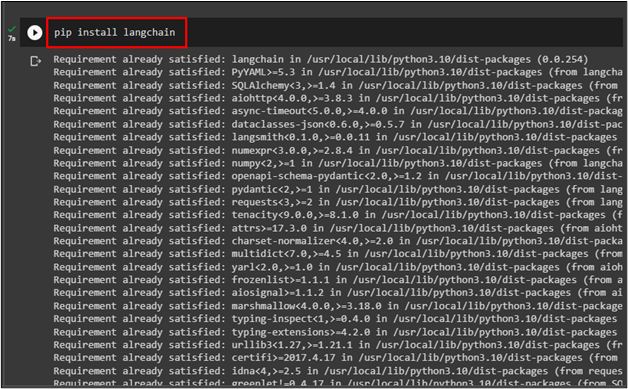

Voordat u het interactieproces met LLM's start met behulp van LangChain, installeert u de ' langketen ”-module met behulp van de volgende code:

Pip installeren langketen

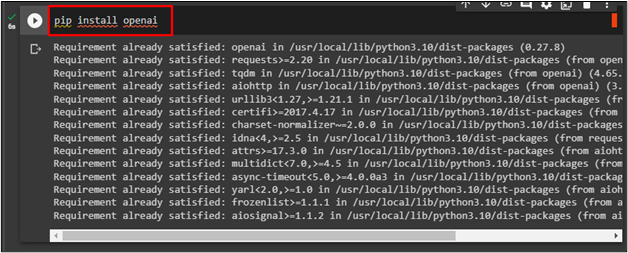

Om het OpenAI-framework te installeren, gebruikt u de API-sleutel voor interactie met LLM's via de volgende code:

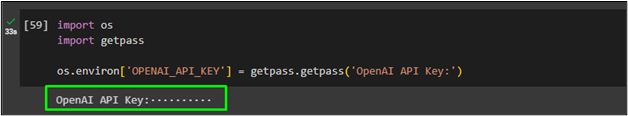

Importeer nu “ Jij ' En ' Krijg een pas ” om de OpenAI API-sleutel te gebruiken na het uitvoeren van de code:

importeer ons

getpass importeren

os.omgeving [ 'OPENAI_API_KEY' ] = getpass.getpass ( 'OpenAI API-sleutel:' )

LLM bellen

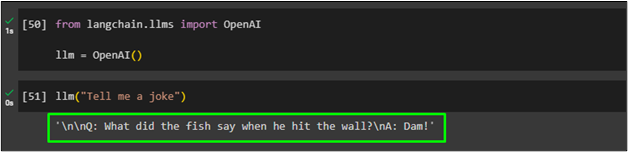

Importeer de OpenAI-bibliotheek uit de LangChain-module om de functie ervan toe te wijzen aan de “ llm ”variabele:

van langchain.llms importeer OpenAIllm = OpenAI ( )

Bel daarna eenvoudigweg de “ llm '-functie en de promptquery als parameter:

Genereer meerdere teksten met behulp van LLM's

Gebruik de methode generator() met meerdere aanwijzingen in natuurlijke taal om de tekst uit LLM te genereren en deze op te slaan in de map “ llm_resultaat ”variabele:

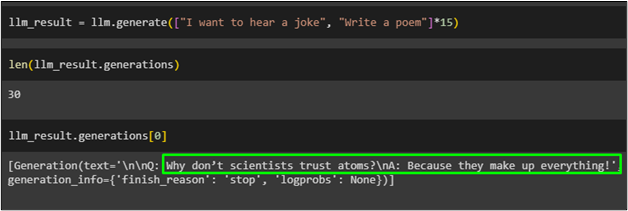

llm_result = llm.generate ( [ 'Ik wil een grap horen' , 'Schrijf een gedicht' ] * vijftien )

Haal de lengte op van de objecten die zijn opgeslagen in de “ llm_resultaat ”variabele met behulp van de functie genereren():

Roep eenvoudigweg de variabele aan met het indexnummer van de objecten:

De volgende schermafbeelding toont de tekst die is opgeslagen in het bestand “ llm_resultaat ”variabele op de 0-index die de grap genereert:

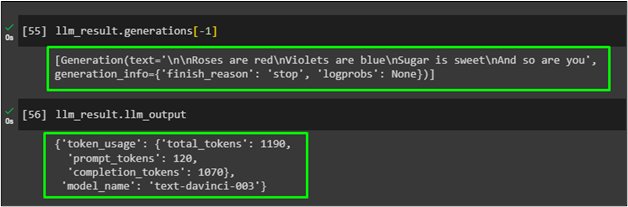

Gebruik de methodegenerations() met de parameter index -1 om het gedicht te genereren dat in de variabele llm_result is geplaatst:

Geef eenvoudigweg de gegenereerde uitvoer weer in de resultaatvariabele om de providerspecifieke informatie te krijgen die is gegenereerd in de vorige LLM met behulp van de gegenereerde functie:

Dat gaat allemaal over interactie met LLM's met behulp van het LangChain-framework om natuurlijke taal te genereren.

Conclusie

Om te communiceren met grote taalmodellen met behulp van LangChain, installeert u eenvoudigweg frameworks zoals LangChain en OpenAI om bibliotheken voor LLM's te importeren. Geef daarna de OpenAI API-sleutel op die u kunt gebruiken als LLM's voor het begrijpen of genereren van de natuurlijke taal. Gebruik de LLM voor de invoerprompt in natuurlijke taal en roep deze vervolgens aan om tekst te genereren op basis van de opdracht. In deze handleiding wordt het proces van interactie met de grote taalmodellen uitgelegd met behulp van LangChain-modules.