Deze handleiding illustreert het proces van het uitvoeren van LLMChains in LangChain.

Hoe LLMChains in LangChain uit te voeren?

LangChain biedt de functies of afhankelijkheden voor het bouwen van LLMChains met behulp van de LLM's/Chatbots en promptsjablonen. Om het proces van het bouwen en uitvoeren van de LLMChains in LangChain te leren, volgt u eenvoudigweg de volgende stapsgewijze handleiding:

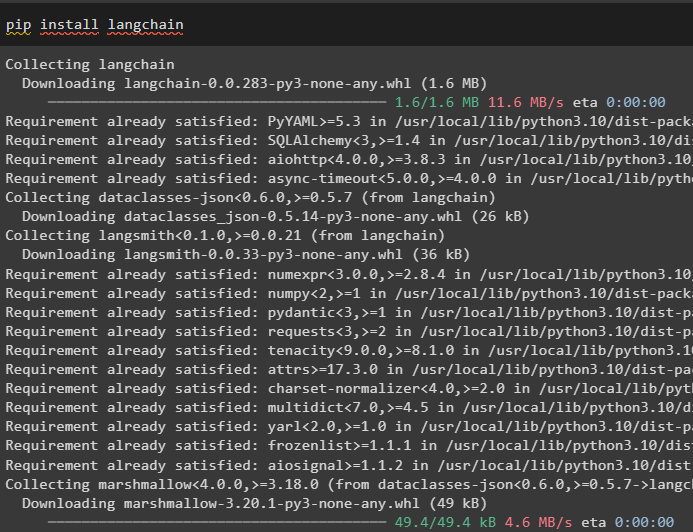

Stap 1: Installeer pakketten

Ga eerst aan de slag met het proces door de LangChain-module te installeren om de afhankelijkheden voor het bouwen en uitvoeren van LLMChains te verkrijgen:

pip installeer langchain

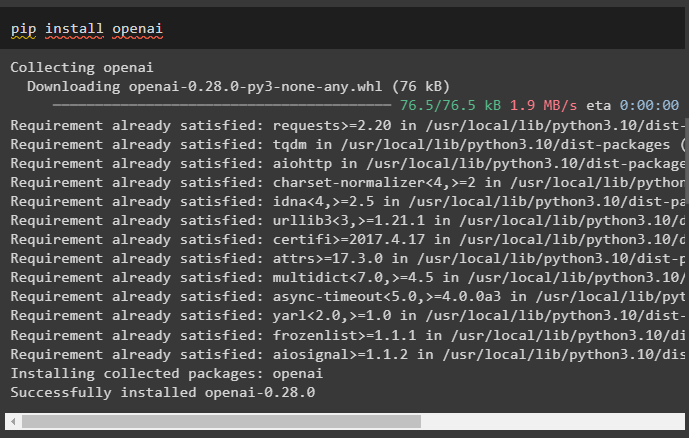

Installeer het OpenAI-framework met behulp van de pip-opdracht om de bibliotheken de OpenAI()-functie te laten gebruiken voor het bouwen van LLM's:

pip installeer openai

Na de installatie van modules eenvoudig de omgeving opzetten variabelen met behulp van de API-sleutel van het OpenAI-account:

importeren Jij

importeren Krijg een pas

Jij . ongeveer [ 'OPENAI_API_KEY' ] = Krijg een pas . Krijg een pas ( 'OpenAI API-sleutel:' )

Stap 2: Bibliotheken importeren

Zodra de installatie is voltooid en alle vereiste pakketten zijn geïnstalleerd, importeert u de vereiste bibliotheken voor het bouwen van de promptsjabloon. Bouw daarna eenvoudigweg de LLM met behulp van de OpenAI()-methode en configureer de LLMChain met behulp van de LLM's en de promptsjabloon:

van langketen importeren Promptsjabloonvan langketen importeren Open AI

van langketen importeren LLMChain

prompt_sjabloon = 'geef me een goede titel voor een bedrijf dat {product} maakt?'

llm = Open AI ( temperatuur = 0 )

llm_chain = LLMChain (

llm = llm ,

snel = Promptsjabloon. Van sjabloon ( prompt_sjabloon )

)

llm_chain ( 'kleurrijke kleding' )

Stap 3: Kettingen laten lopen

Haal de invoerlijst op met verschillende producten die door het bedrijf zijn geproduceerd en voer de keten uit om de lijst op het scherm weer te geven:

invoerlijst = [{ 'Product' : 'sokken' } ,

{ 'Product' : 'computer' } ,

{ 'Product' : 'schoenen' }

]

llm_chain. toepassen ( invoerlijst )

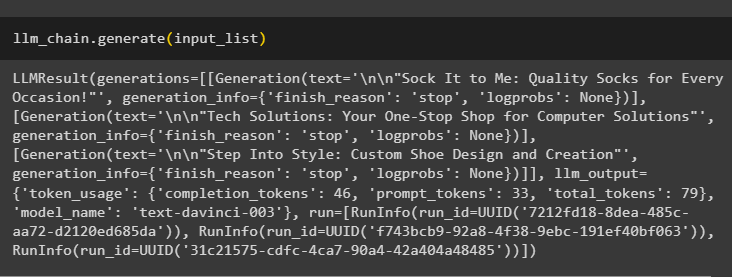

Voer de methode genereren() uit met behulp van de invoerlijst met LLMChains om de uitvoer te krijgen die verband houdt met het gesprek dat door het model is gegenereerd:

llm_chain. genereren ( invoerlijst )

Stap 4: Eén invoer gebruiken

Voeg nog een product toe om de LLMChains uit te voeren door slechts één enkele invoer te gebruiken en voorspel vervolgens dat de LLMChain de uitvoer zal genereren:

llm_chain. voorspellen ( Product = 'kleurrijke sokken' )Stap 5: Meerdere ingangen gebruiken

Bouw nu de sjabloon voor het gebruik van meerdere invoergegevens voor het leveren van de opdracht aan het model voordat u de keten uitvoert:

sjabloon = '''Vertel me een {bijvoeglijk naamwoord} grapje over {onderwerp}.'''snel = Promptsjabloon ( sjabloon = sjabloon , invoervariabelen = [ 'bijvoeglijk naamwoord' , 'onderwerp' ] )

llm_chain = LLMChain ( snel = snel , llm = Open AI ( temperatuur = 0 ) )

llm_chain. voorspellen ( bijvoeglijk naamwoord = 'verdrietig' , onderwerp = 'eenden' )

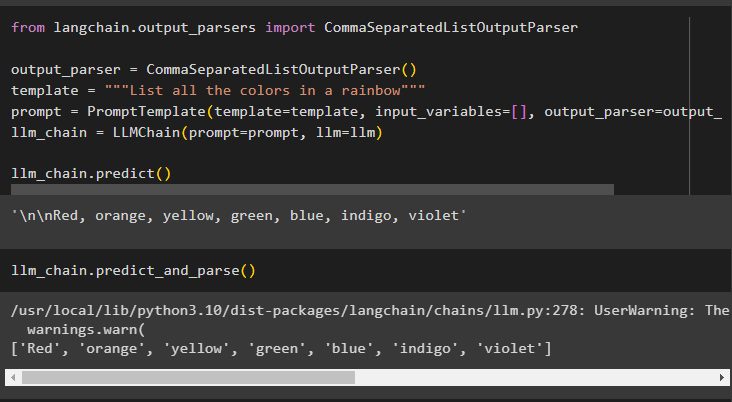

Stap 6: Uitvoerparser gebruiken

Deze stap gebruikt de uitvoerparsermethode om de LLMChain uit te voeren om de uitvoer te verkrijgen op basis van de prompt:

van langketen. uitvoer_parsers importeren CommaSeparatedListOutputParseruitvoer_parser = CommaSeparatedListOutputParser ( )

sjabloon = '''Maak een lijst van alle kleuren in een regenboog'''

snel = Promptsjabloon ( sjabloon = sjabloon , invoervariabelen = [ ] , uitvoer_parser = uitvoer_parser )

llm_chain = LLMChain ( snel = snel , llm = llm )

llm_chain. voorspellen ( )

Als u de methode parse() gebruikt om de uitvoer te verkrijgen, wordt een door komma's gescheiden lijst van alle kleuren in de regenboog gegenereerd:

llm_chain. voorspellen_en_parseren ( )

Stap 7: Initialiseren vanaf strings

In deze stap wordt het proces uitgelegd van het gebruik van een tekenreeks als prompt om de LLMChain uit te voeren met behulp van het LLM-model en de sjabloon:

sjabloon = '''Vertel me een {bijvoeglijk naamwoord} grap over {onderwerp}'''llm_chain = LLMChain. van_string ( llm = llm , sjabloon = sjabloon )

Geef de waarden van de variabelen op in de tekenreeksprompt om de uitvoer van het model op te halen door LLMChain uit te voeren:

llm_chain. voorspellen ( bijvoeglijk naamwoord = 'verdrietig' , onderwerp = 'eenden' )Dat gaat allemaal over het uitvoeren van de LLMChains met behulp van het LangChain-framework.

Conclusie

Om de LLMChains in LangChain te bouwen en uit te voeren, installeert u de vereisten zoals pakketten en stelt u de omgeving in met behulp van de API-sleutel van OpenAI. Importeer daarna de vereiste bibliotheken voor het configureren van de promptsjabloon en het model voor het uitvoeren van LLMChain met behulp van de LangChain-afhankelijkheden. De gebruiker kan uitvoerparsers en tekenreeksopdrachten gebruiken om LLMChains uit te voeren, zoals gedemonstreerd in de handleiding. In deze handleiding wordt het volledige proces van het uitvoeren van de LLMChains in LangChain uitgewerkt.