Dit bericht illustreert het proces van het bouwen van LangChain-applicaties met behulp van Prompt Template en Output Parser.

Hoe LangChain-applicaties bouwen met behulp van Prompt Template en Output Parser?

Om de LangChain-applicatie te bouwen met behulp van de promptsjabloon en uitvoerparser, volgt u eenvoudigweg deze eenvoudige handleiding:

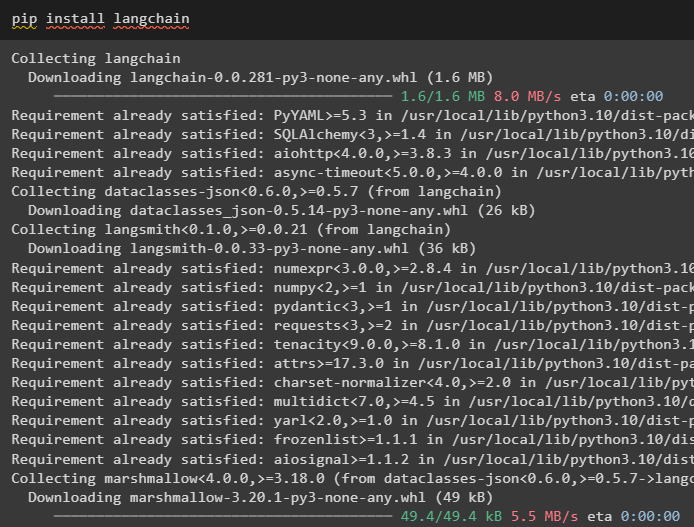

Stap 1: Installeer LangChain

Start eerst het proces van het bouwen van LangChain-applicaties door het LangChain-framework te installeren met behulp van de “ Pip ” commando:

pip installeer langchain

Stap 2: Prompt-sjabloon gebruiken

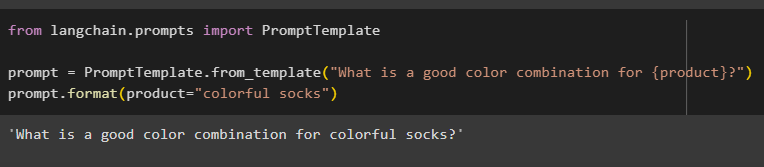

Na het installeren van de LangChain-modules importeert u de “ Promptsjabloon ”-bibliotheek om een promptsjabloon te bouwen door een query aan het model te geven om de vraag te begrijpen:

van langchain.prompts importeer PromptTemplate

prompt = PromptTemplate.from_template('Wat is een goede kleurencombinatie voor {product}?')

prompt.format(product=”kleurrijke sokken”)

De uitvoer combineerde automatisch de zin met de waarde van de “ Product ”variabele:

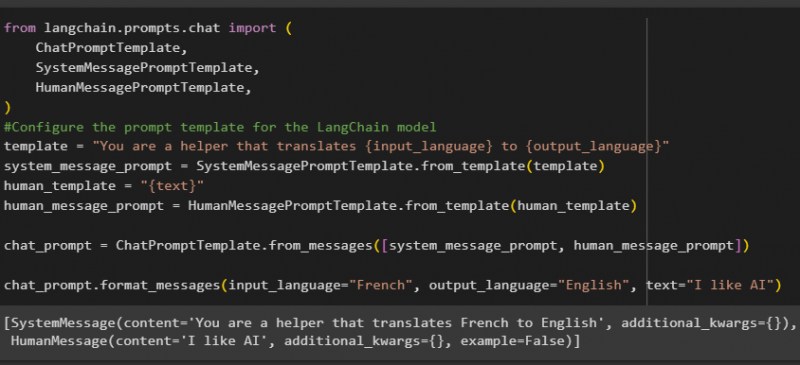

Bouw daarna nog een promptsjabloon door de bibliotheken HumanMessagePromptTemplate, ChatPromptTemplate en SystemMessagePromptTemplate uit de LangChain te importeren:

van langchain.prompts.chat import (ChatPrompt-sjabloon,

SysteemBerichtPrompt-sjabloon,

HumanMessagePrompt-sjabloon,

)

#Configureer de promptsjabloon voor het LangChain-model

template = 'Je bent een helper die {input_taal} vertaalt naar {output_taal}'

system_message_prompt = SystemMessagePromptTemplate.from_template(sjabloon)

human_template = '{tekst}'

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt, human_message_prompt])

chat_prompt.format_messages(input_taal='Frans', output_taal='Engels', text='Ik hou van AI')

Nadat u alle vereiste bibliotheken heeft geïmporteerd, kunt u eenvoudigweg de aangepaste sjabloon voor de query's samenstellen met behulp van de sjabloonvariabele:

De promptsjablonen worden alleen gebruikt om de sjabloon voor de query/vraag in te stellen en antwoorden niet met enig antwoord op de vraag. De functie OutputParser() kan echter antwoorden extraheren, zoals in de volgende sectie aan de hand van het voorbeeld wordt uitgelegd:

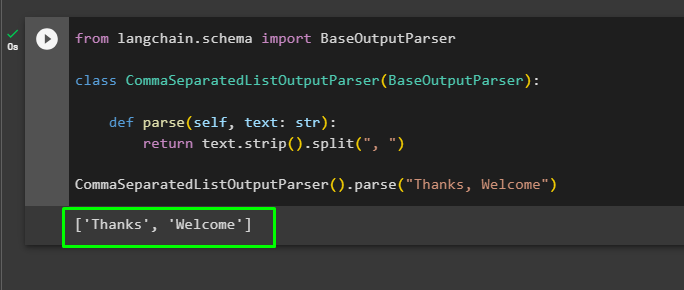

Stap 3: Uitvoerparser gebruiken

Importeer nu de BaseOutputParser-bibliotheek uit LangChain om de tekstwaarden te scheiden, gescheiden door komma's, en retourneer de lijst in de uitvoer:

van langchain.schema importeer BaseOutputParserklasse CommaSeparatedListOutputParser (BaseOutputParser):

def parse(zelf, tekst: str):

return tekst.strip().split(', ')

CommaSeparatedListOutputParser().parse('Bedankt, welkom')

Dat gaat allemaal over het bouwen van de LangChain-applicatie met behulp van de promptsjabloon en uitvoerparser.

Conclusie

Om een LangChain-applicatie te bouwen met behulp van de promptsjabloon en de uitvoerparser, installeert u eenvoudigweg LangChain en importeert u er bibliotheken uit. De PromptTemplate-bibliotheek wordt gebruikt om de structuur voor de query op te bouwen, zodat het model de vraag kan begrijpen voordat informatie wordt geëxtraheerd met behulp van de functie Parser(). De functie OutputParser() wordt gebruikt om antwoorden op te halen op basis van de eerder aangepaste zoekopdrachten. In deze handleiding wordt het proces uitgelegd van het bouwen van LangChain-applicaties met behulp van de promptsjabloon en uitvoerparser.